アップルは8月5日、オンライン上の児童ポルノ対策として、通報された児童性的虐待資料(CSAM)をユーザーのiCloud Photosデータと自動照合する機能を2021年後半から実装すると発表した。ユーザーのプライバシーを保護しながら、児童ポルノ画像の拡散を体系的に防止する。またメッセージアプリでの画像送信時にも警告を表示する。

自動照合では、まず、米国国立行方不明・搾取児童センター(NCMEC)等の保護団体から提供された児童性的虐待資料(CSAM)をアップル側がサーバーに登録。その後、ユーザーのデバイスからiCloud Photosにアップロードされる際に、サーバー側ではなくデバイス側で自動検知する。検知はプライベートセットインターセクションと呼ばれる暗号技術を使用し、ハッシュ値で照合。閾値秘密分散と呼ばれる別の技術を用いて、照合レベルが一定の閾値を超えた場合にのみ、デバイスからアップルのサーバーに通知される。通知後は、再度アップル側で手動で画像の照合を行い、一致と判断すると、司法当局に通報。さらにユーザーのアカウントを無効にする。同機能は、

アップルは、この機能では、疑わしいと判断されるまで、デバイス側の情報をアップル側に通知しないことでプライバシーに配慮していると主張。また、閾値は極めて高精度で設定されており、特定のアカウントに誤ってフラグを立てる確率は年間で1兆分の1以下となっていると伝えた。ユーザーは、自分のアカウントに誤ってフラグを立てられたと感じた場合、アカウントを復活させるための異議申し立てを行うことができる。実装は、iPhoneとiPadで行う予定。

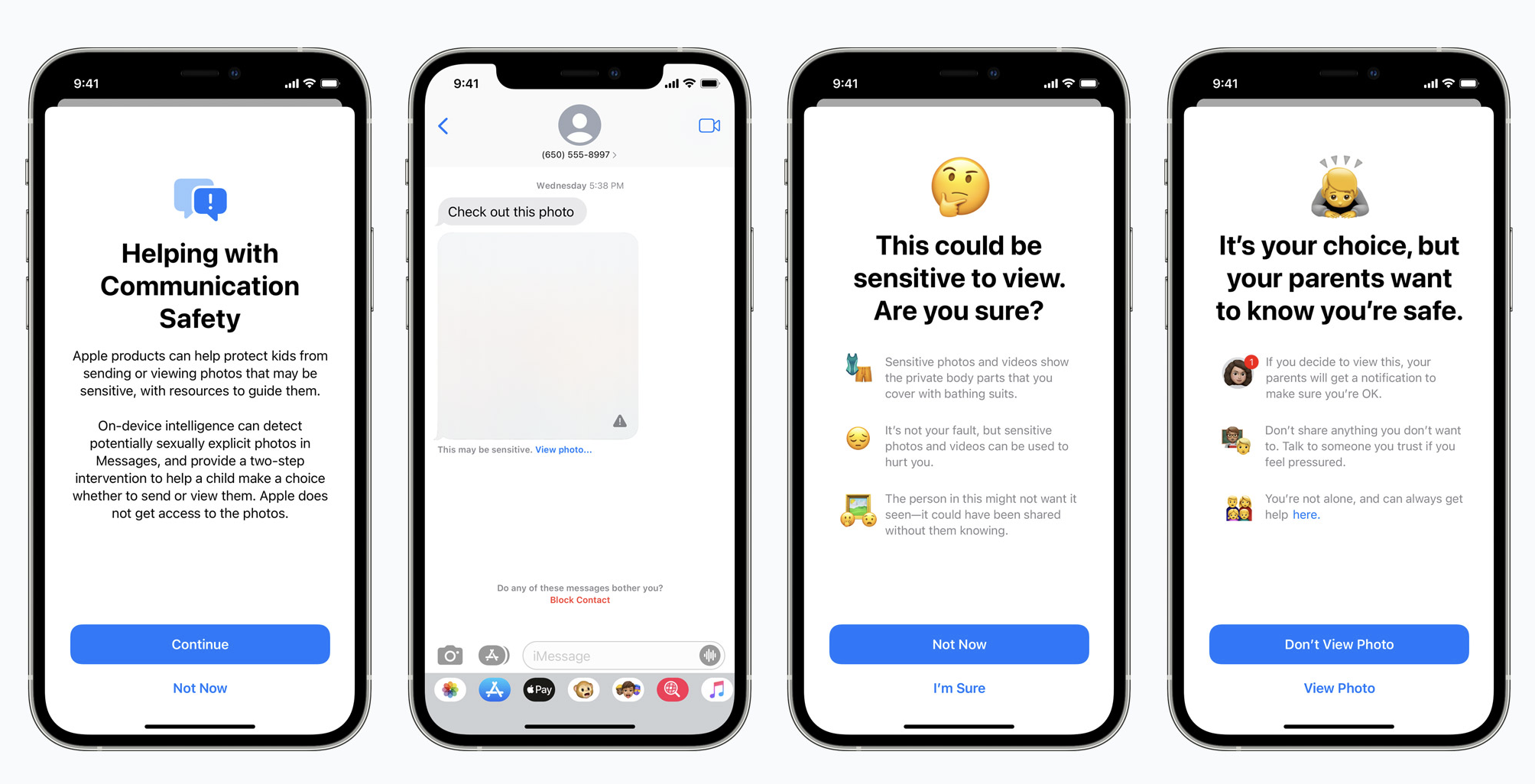

メッセージアプリへの警告表示では、ポルノ画像を受信したり、送信したりする際に、子供のユーザーや、その親に警告メッセージを通知するというもの。機能は、iOS 15、iPadOS 15、macOS Montereyで、iCloudで家族として設定されたアカウントが対象となる。2021年後半のOSアップデートで実装する。

同機能では、メッセージ内容は読み取らないまま、添付された画像がポルノ画像か否かを機械学習機能で判断。ポルノ画像と判断されると、画像がぼかされ、子供のユーザーに警告が表示される。閲覧ボタンをクリックすると画像は閲覧できるが、家族アカウントで設定されている親にメッセージが通知される。同様に、子供がポルノ画像と判断される画像をメッセージアプリで送信する際にも、事前に子供に警告表示されるとともに、送信した場合は親にメッセージ通知される。

さらにSiriや検索でも対策を進める。ユーザーがSiriや検索で、児童性的虐待資料の検索を行った場合に、テーマへの関心が有害であることをユーザーに説明するメッセージを表示する。また児童性的虐待資料対策のために、通報を行う手段を検索した場合には、専用の情報ソースを表示する。これらの機能も、iOS 15、iPadOS 15、macOS Montereyが対象で、2021年後半のOSアップデートで実装する。

【参照ページ】Expanded Protections for Children

【画像】Apple

Sustainable Japanの特長

Sustainable Japanは、サステナビリティ・ESGに関する

様々な情報収集を効率化できる専門メディアです。

- 時価総額上位100社の96%が登録済

- 業界第一人者が編集長

- 7記事/日程度追加、合計11,000以上の記事を読める

- 重要ニュースをウェビナーで分かりやすく解説※1

さらに詳しく

ログインする

※1:重要ニュース解説ウェビナー「SJダイジェスト」。詳細はこちら

Skip navigation

Skip navigation

Skip navigation

Skip navigation